Mi az a token (PixelRita)?

A „token” a ChatGPT világában olyan, mint a szavak kicsi, cuki testvérei, amiket a gépi tanulás használ az információk feldolgozására. Képzeld el, mint egy nagy puzzle játékot, ahol minden darab egy kis része a nagy képnek. A tokenek pont ilyenek: kis darabkák, amik segítenek a gépnek megérteni, mit mondasz neki.

Amikor beszélsz a ChatGPT-vel, a gép először „tokenizálja” a szöveget. Ez olyan, mint amikor egy nagy mondatot szótagokra bontasz, hogy könnyebben megértsd. Például a mondat: „Szia, hogy vagy?” Tokenizálás után így néz ki: [„Szia”, „,”, „hogy”, „vagy”, „?”]. Minden szó, írásjel, sőt néha még a szótagok is külön tokenekké válnak.

Ezek a tokenek aztán útjukra indulnak a gépi tanulás varázslatos világában. Itt a gép megnézi, hogy milyen kapcsolatban állnak egymással a tokenek, hogy megértse, mit akarsz mondani. Mintha egy kirakós játékot rakna össze, ahol minden darabka egy újabb információt jelent.

Például, ha azt írod, hogy „Szeretem a pizzát”, a tokenek lehetnek: [„Szeretem”, „a”, „pizzát”]. A gép ezekből a tokenekből értelmezi, hogy valami pozitívat mondasz egy finom ételről.

Ahogyan a ChatGPT számolja a tokeneket

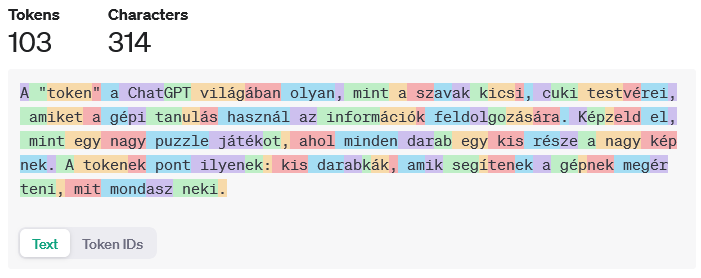

A következő dolgokat érdemes tudni, amikor tokeneket számolunk. Ezek leginkább az API esetében fontos, ahol minden token után fizetünk.

- A tokeneket az elküldött kérdések és a kapott válaszok alapján számolja.

- Minden beszélgetés kezdetén is keletkezik token. Ez a beszélgetés azonosítója, és egyéb jelölések.

- Mivel a program a teljes beszélgetés alapján írja a válaszokat. Ezért nemcsak az újabb üzenetben lévő tokenekkel kell számolni, hanem a komplett beszélgetés folyamatban lévőkkel. Hacsak nincs kontextus váltás.

Magyar nyelven több tokent használunk?

Igen. A ChatGPT főleg angol nyelven lett tréningezve. Egy szót minél többször lát a program a tanulás során, annál biztosabb, hogy azt egy tokennek fogja használni. Mivel jóval kevesebb magyar szót lát a program, ezért a szavakat több és kisebb részekre osztja. A speciális magyar karakterek, az ékezetes betűk további tokenekre bontják a szavakat.

Ugyan az a tartalom magyar nyelven kb. kétszer-háromszor annyi tokent jelent, mint angolul.

További érdekességek a tokenekről Piller Balázs írásában: Miért drágább a ChatGPT magyarul, mint angolul?

Az OpenAI egy külön programot is készített, ami segít a tokenek megértésében, és a token számításban: OpenAI Tokenizer

![]()